|

Обновление сертификатов oVirt |

Автор: casm

[комментарии]

|

| | oVirt - свободная, кроссплатформенная система управления виртуализацией.

Была разработана компанией Red Hat как проект сообщества, на котором основан

продукт Red Hat Virtualization.

oVirt состоит из двух основных компонентов - oVirt engine и oVirt node.

oVirt engine управляет всеми хостами виртуализации, общими дисковыми ресурсами

и виртуальными сетями. Может быть размещён как на отдельном сервере

(standalone), так и на виртуальной машине внутри гипервизоров, которыми

управляет (self-hosted engine).

oVirt node - физический сервер с RHEL, Centos, Scientific Linux с KVM

гипервизором и службой VDSM (Virtual Desktop and Server Manager), которая

управляет всеми ресурсами, доступными серверу (вычисления, ОЗУ, хранилище,

сеть), а также управляет запуском виртуальных машин. Несколько узлов могут быть

объединены в кластер.

В примерах ниже будут один oVirt engine и три oVirt node:

oVirt engine - virt-he.example.test

oVirt node - virt-host1.example.test, virt-host2.example.test, virt-host3.example.test

Обмен данными между oVirt engine и oVirt node осуществляется с использованием SSL-сертификатов.

Автоматическое обновление сертификатов не производится, поэтому очень

важно обновлять сертификаты вручную до истечения сроков их действия.

Стандартными средствами обновить сертификаты можно, если до окончания срока

действия осталось менее 60 дней (для версии 4.5).

В oVirt необходимо обновлять вручную два типа сертификатов:

сертификаты oVirt Engine - службы, которая предоставляет графический

интерфейс и REST API для управления ресурсами виртуальных машин

сертификаты для обмена данным между гипервизорами oVirt node и центром

управления виртуальными машинами oVirt Engine

Определить дату окончания действия сертификатов oVirt Engine можно в свойствах сертификата сайта.

Определить дату окончания действия сертификатов oVirt node можно с помощью openssl:

Подключаемся через SSH на физический сервер oVirt node

Определяем дату:

[root@virt-host1 ~]# openssl x509 -noout -enddate -in /etc/pki/vdsm/certs/vdsmcert.pem

В версиях oVirt до 4.5, у всех сертификатов время жизни составляет 398 дней.

Начиная с версии 4.5, у самоподписанных сертификатов для обмена данным между

гипервизорами oVirt node и центром управления виртуальными машинами oVirt

engine установлено время действия 5 лет.

У сертификатов, которые видят браузеры, срок действия установлен в 398 дней, их

необходимо обновлять раз в год.

Процедура обновления действующих сертификатов описана в официальной документации.

Если вы допустите истечение срока действия сертификатов, то гипервизоры и

центр управления Engine перестанут взаимодействовать.

В Web-консоль невозможно будет войти, виртуальные машины продолжать работать,

но с ними ничего нельзя будет сделать: нельзя изменить параметры виртуального

железа, нельзя мигрировать на другой узел, после выключения ВМ её будет

невозможно включить снова.

Восстановление займёт много времени.

Процедура восстановления просроченных сертификатов описана в руководстве.

Для доступа к нему необходима действующая платная подписка Red Hat

Virtualization (RHV) 4.x.

Решение для восстановления без подписки я обнаружил на GitHub.

Автор подготовил решения для Ansible в соответствии с рекомендациями от Red

Hat. Если вы знакомы с Ansible и у вас много гипервизоров с просроченными

сертификатами, то можно использовать решение от natman.

Решение ниже подходит для небольшого числа гипервизоров, но при условии, что

центр управления Engine у вас запущен, и вы можете получить к нему доступ через

ssh. Предполагается, что в качестве центра управления используется HostedEngine

- центр управления гипервизорами запускается внутри самого гипервизора.

Если центр управления Engine выключен и не запускается, а в журнале journalctl

на гипервизоре появляются записи

libvirtd[2101]: The server certificate /etc/pki/vdsm/certs/vdsmcert.pem has expired

...

systemd[1]: Failed to start Virtualization daemon

то единственным вариантом восстановления будет изменение времени на гипервизоре

на более ранее (в пределах срока действия сертификатов) и обновление

сертификатов стандартным образом.

Обновление сертификатов до истечения сроков действия

Обновление сертификатов oVirt node

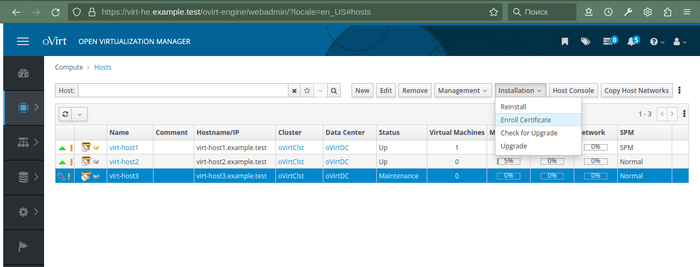

Переводим узел (гипервизор) в режим обслуживания (Managеment -> Maintenance) -

все машины на узле будут мигрированы, привязанные (pinned) машины будут выключены.

Выбираем Installation -> Enroll Certificate

Выбираем Installation -> Enroll Certificate

Выводим узел из режима обслуживания

Выводим узел из режима обслуживания

Повторяем операции для всех оставшихся узлов в кластере

Обновление сертификатов oVirt Engine

Подключаемся к физическому серверу гипервизору oVirt node через SSH

С узла Ovirt host переводим центр управления ВМ в режим обслуживания (для

Self-hosted типа развёртывания)

[root@virt-host1 ~]# hosted-engine --set-maintenance --mode=global

Подключаемся к виртуальной машине с центром управления oVirt engine через SSH,

запускаем настройку engine (web-консоль будет остановлена)

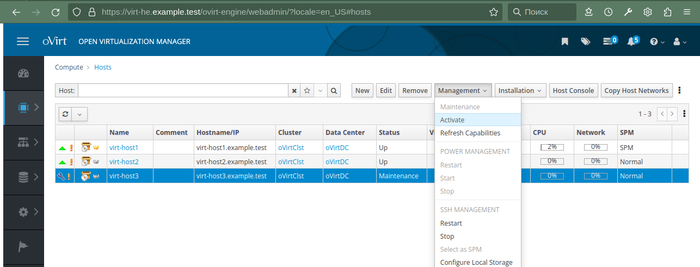

[root@virt-he ~]# engine-setup --offline

Отвечаем на вопросы

Если до истечения срока действия сертификата осталось менее 60 дней,

то скрипт предложит обновить сертификаты:

Renew certificates? (Yes, No) [No]: Yes

Повторяем операции для всех оставшихся узлов в кластере

Обновление сертификатов oVirt Engine

Подключаемся к физическому серверу гипервизору oVirt node через SSH

С узла Ovirt host переводим центр управления ВМ в режим обслуживания (для

Self-hosted типа развёртывания)

[root@virt-host1 ~]# hosted-engine --set-maintenance --mode=global

Подключаемся к виртуальной машине с центром управления oVirt engine через SSH,

запускаем настройку engine (web-консоль будет остановлена)

[root@virt-he ~]# engine-setup --offline

Отвечаем на вопросы

Если до истечения срока действия сертификата осталось менее 60 дней,

то скрипт предложит обновить сертификаты:

Renew certificates? (Yes, No) [No]: Yes

Дожидаемся окончания работы скрипта.

С узла Ovirt host выводим центр управления ВМ из режима обслуживания:

[root@virt-host1 ~]# hosted-engine --set-maintenance --mode=none

Подключаемся к web-консоли и проверяем дату окончания действия сертификата.

Обновление сертификатов после истечения сроков действия

Если вы допустите истечение срока действия сертификатов, то в web-консоль невозможно будет войти.

Дожидаемся окончания работы скрипта.

С узла Ovirt host выводим центр управления ВМ из режима обслуживания:

[root@virt-host1 ~]# hosted-engine --set-maintenance --mode=none

Подключаемся к web-консоли и проверяем дату окончания действия сертификата.

Обновление сертификатов после истечения сроков действия

Если вы допустите истечение срока действия сертификатов, то в web-консоль невозможно будет войти.

Гипервизоры и центр управления Engine перестанут взаимодействовать.

Гипервизоры и центр управления Engine перестанут взаимодействовать.

Чтобы восстановить сертификаты выполняем следующие шаги.

Подключаемся через SSH на узел гипервизора oVirt node с истёкшим сертификатом

(в примере имя узла virt-host1).

Создаем запрос сертификата на основании ключа службы VDSM /etc/pki/vdsm/keys/vdsmkey.pem

[root@virt-host1 ~]# openssl req -new \

-key /etc/pki/vdsm/keys/vdsmkey.pem \

-out /tmp/test_virt-host1_vdsm.csr \

-batch \

-subj "/"

Подписываем запрос с помощью корневого сертификата oVirt engine, для этого

подключаемся через SSH на ВМ с oVirt engine, копируем запрос с oVirt node

(virt-host1) на oVirt engine в /tmp и выполняем команды

[root@virt-he ~]# cd /etc/pki/ovirt-engine/

[root@virt-he ~]# openssl ca -batch \

-policy policy_match \

-config openssl.conf \

-cert ca.pem \

-keyfile private/ca.pem \

-days +"365" \

-in /tmp/test_virt-host1_vdsm.csr \

-out /tmp/test_virt-host1_vdsm.cer \

-startdate `(date --utc --date "now -1 days" +"%y%m%d%H%M%SZ")` \

-subj "/O=example.test/CN=virt-host1.example.test\

-utf8

Имя субъекта в сертификате должно быть в формате

"/O=example.test/CN=virt-host1.example.test", укажите ваши значения.

Копируем новый сертификат с oVirt engine на oVirt node (virt-host1) в /tmp.

Копируем новый сертификат в каталоги служб предварительно создав копию существующих сертификатов

[root@virt-host1 ~]# cp /etc/pki/vdsm/certs/vdsmcert.pem /etc/pki/vdsm/certs/vdsmcert.pem.bak

[root@virt-host1 ~]# cp /tmp/test_virt-host1_vdsm.cer /etc/pki/vdsm/certs/vdsmcert.pem

[root@virt-host1 ~]# cp /etc/pki/vdsm/libvirt-spice/server-cert.pem /etc/pki/vdsm/libvirt-spice/server-cert.pem.bak

[root@virt-host1 ~]# cp /etc/pki/vdsm/certs/vdsmcert.pem /etc/pki/vdsm/libvirt-spice/server-cert.pem

[root@virt-host1 ~]# cp /etc/pki/libvirt/clientcert.pem /etc/pki/libvirt/clientcert.pem.bak

[root@virt-host1 ~]# cp /etc/pki/vdsm/certs/vdsmcert.pem /etc/pki/libvirt/clientcert.pem

Перезапускаем службы:

[root@virt-host1 ~]# systemctl restart libvirtd

[root@virt-host1 ~]# systemctl restart vdsmd

Проверяем срок действия сертификата

[root@virt-host1 ~]# openssl x509 -noout -enddate -in /etc/pki/vdsm/certs/vdsmcert.pem

Повторяем процедуру на остальных узлах с истёкшим сроком действия сертификатов.

Выполняем обновления сертификатов центра управления, как описано в "Обновление

сертификатов oVirt Engine"

Заходим на web-консоль и проверяем работу кластера.

У созданных таким образом сертификатов будет отсутствовать subject alternative

name, о чём будет выдано предупреждение (через несколько часов):

Certificate of host virt-host1.example.test is invalid. The

certificate doesn't contain valid subject alternative name, please

enroll new certificate for the host.

Поэтому после восстановления доступа к web-консоли необходимо выполнить

обновление сертификатов согласно официальной документации.

Обновление сертификатов после истечения сроков действия при недоступном HostedEngine

На практике данное решение не проверялось, но теоретически оно должно сработать.

Если центр управления Engine выключен и не запускается, а в журнале journalctl

на гипервизоре появляются записи

libvirtd[2101]: The server certificate /etc/pki/vdsm/certs/vdsmcert.pem has expired

...

systemd[1]: Failed to start Virtualization daemon

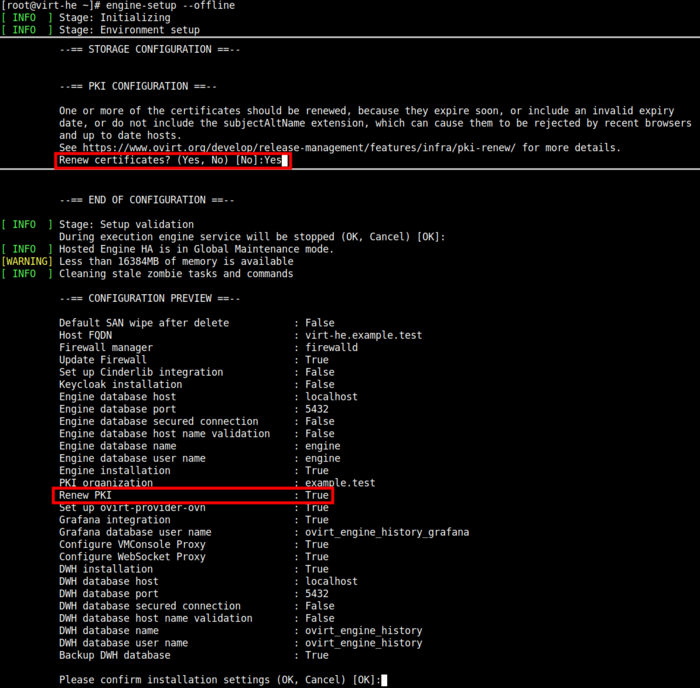

Оставляем включенным один гипервизор oVirt node.

Определяем время окончания действия сертификата гипервизора:

[root@virt-host1 ~]# openssl x509 -noout -enddate -in /etc/pki/vdsm/certs/vdsmcert.pem

Устанавливаем дату и время до окончания действия сертификата

[root@virt-host1 ~]# systemctl stop chronyd

[root@virt-host1 ~]# timedatectl set-time "2023-01-01 12:00:00"

Перезапускаем службы

[root@virt-host1 ~]# systemctl restart libvirtd

[root@virt-host1 ~]# systemctl restart vdsmd

Подключаемся к libvirtd через virsh и ждём, когда запустится HostedEngine

[root@virt-host1 ~]# virsh -c qemu:///system?authfile=/etc/ovirt-hosted-engine/virsh_auth.conf

virsh # list --all

Id Name State

------------------------------

1 HostedEngine running

Выполняем обновление сертификатов по процедуре "Обновление сертификатов до

истечения сроков действия"

Использованные материалы

Документация oVirt

Проект natman

Wikipedia

Блог IT-KB

Чтобы восстановить сертификаты выполняем следующие шаги.

Подключаемся через SSH на узел гипервизора oVirt node с истёкшим сертификатом

(в примере имя узла virt-host1).

Создаем запрос сертификата на основании ключа службы VDSM /etc/pki/vdsm/keys/vdsmkey.pem

[root@virt-host1 ~]# openssl req -new \

-key /etc/pki/vdsm/keys/vdsmkey.pem \

-out /tmp/test_virt-host1_vdsm.csr \

-batch \

-subj "/"

Подписываем запрос с помощью корневого сертификата oVirt engine, для этого

подключаемся через SSH на ВМ с oVirt engine, копируем запрос с oVirt node

(virt-host1) на oVirt engine в /tmp и выполняем команды

[root@virt-he ~]# cd /etc/pki/ovirt-engine/

[root@virt-he ~]# openssl ca -batch \

-policy policy_match \

-config openssl.conf \

-cert ca.pem \

-keyfile private/ca.pem \

-days +"365" \

-in /tmp/test_virt-host1_vdsm.csr \

-out /tmp/test_virt-host1_vdsm.cer \

-startdate `(date --utc --date "now -1 days" +"%y%m%d%H%M%SZ")` \

-subj "/O=example.test/CN=virt-host1.example.test\

-utf8

Имя субъекта в сертификате должно быть в формате

"/O=example.test/CN=virt-host1.example.test", укажите ваши значения.

Копируем новый сертификат с oVirt engine на oVirt node (virt-host1) в /tmp.

Копируем новый сертификат в каталоги служб предварительно создав копию существующих сертификатов

[root@virt-host1 ~]# cp /etc/pki/vdsm/certs/vdsmcert.pem /etc/pki/vdsm/certs/vdsmcert.pem.bak

[root@virt-host1 ~]# cp /tmp/test_virt-host1_vdsm.cer /etc/pki/vdsm/certs/vdsmcert.pem

[root@virt-host1 ~]# cp /etc/pki/vdsm/libvirt-spice/server-cert.pem /etc/pki/vdsm/libvirt-spice/server-cert.pem.bak

[root@virt-host1 ~]# cp /etc/pki/vdsm/certs/vdsmcert.pem /etc/pki/vdsm/libvirt-spice/server-cert.pem

[root@virt-host1 ~]# cp /etc/pki/libvirt/clientcert.pem /etc/pki/libvirt/clientcert.pem.bak

[root@virt-host1 ~]# cp /etc/pki/vdsm/certs/vdsmcert.pem /etc/pki/libvirt/clientcert.pem

Перезапускаем службы:

[root@virt-host1 ~]# systemctl restart libvirtd

[root@virt-host1 ~]# systemctl restart vdsmd

Проверяем срок действия сертификата

[root@virt-host1 ~]# openssl x509 -noout -enddate -in /etc/pki/vdsm/certs/vdsmcert.pem

Повторяем процедуру на остальных узлах с истёкшим сроком действия сертификатов.

Выполняем обновления сертификатов центра управления, как описано в "Обновление

сертификатов oVirt Engine"

Заходим на web-консоль и проверяем работу кластера.

У созданных таким образом сертификатов будет отсутствовать subject alternative

name, о чём будет выдано предупреждение (через несколько часов):

Certificate of host virt-host1.example.test is invalid. The

certificate doesn't contain valid subject alternative name, please

enroll new certificate for the host.

Поэтому после восстановления доступа к web-консоли необходимо выполнить

обновление сертификатов согласно официальной документации.

Обновление сертификатов после истечения сроков действия при недоступном HostedEngine

На практике данное решение не проверялось, но теоретически оно должно сработать.

Если центр управления Engine выключен и не запускается, а в журнале journalctl

на гипервизоре появляются записи

libvirtd[2101]: The server certificate /etc/pki/vdsm/certs/vdsmcert.pem has expired

...

systemd[1]: Failed to start Virtualization daemon

Оставляем включенным один гипервизор oVirt node.

Определяем время окончания действия сертификата гипервизора:

[root@virt-host1 ~]# openssl x509 -noout -enddate -in /etc/pki/vdsm/certs/vdsmcert.pem

Устанавливаем дату и время до окончания действия сертификата

[root@virt-host1 ~]# systemctl stop chronyd

[root@virt-host1 ~]# timedatectl set-time "2023-01-01 12:00:00"

Перезапускаем службы

[root@virt-host1 ~]# systemctl restart libvirtd

[root@virt-host1 ~]# systemctl restart vdsmd

Подключаемся к libvirtd через virsh и ждём, когда запустится HostedEngine

[root@virt-host1 ~]# virsh -c qemu:///system?authfile=/etc/ovirt-hosted-engine/virsh_auth.conf

virsh # list --all

Id Name State

------------------------------

1 HostedEngine running

Выполняем обновление сертификатов по процедуре "Обновление сертификатов до

истечения сроков действия"

Использованные материалы

Документация oVirt

Проект natman

Wikipedia

Блог IT-KB

|

| |

|

|

|

Создание виртуальных машин с помощью Qemu KVM (доп. ссылка 1) |

Автор: Slonik

[комментарии]

|

| | В статье опишу мой опыт про подготовку и запуск виртуальных машин (ВМ) с

помощью открытых и бесплатных средств виртуализации в Linux - Qemu KVM.

В качестве среды для выполнения виртуальных машин будет использоваться Fedora

Linux 36, аналогично ВМ можно запускать в Centos 8 и выше.

Для запуска ВМ понадобятся пакеты:

qemu-kvm (qemu-system-x86) - эмулятор

qemu-img - средство создания и управления виртуальными дисками

edk2-ovmf - образы прошивки UEFI

Будет рассмотрено три типа виртуальных машин:

Виртуальная машина с BIOS

Виртуальная машина с UEFI

Кластер виртуальных машин с общим диском

Подготовка виртуальной сети

В Qemu я использую два режима подключения сети в гостевую ВМ - user networking

и с использованием устройств tap.

Первый режим проще, не требует root прав, но у него меньше производительность,

в таком режиме не работает протокол ICMP и он не позволяет обратится к ВМ из

физической сети.

Второй режим предоставляет большее быстродействие при работе с сетью, его можно

гибко настраивать, но он требует root права.

Пользовательская виртуальная сеть

Простейшую ВМ с пользовательской сетью можно запустить так:

qemu-kvm \

-m 1G \

-device virtio-net-pci,netdev=lan \

-netdev user,id=lan \

-drive file=/tmp/livecd.iso,media=cdrom

Ключевым параметром, который включает пользовательский режим сети это -netdev user.

Такая команда запустит LiveCD внутри ВМ c 1024 МБ ОЗУ, в качестве сетевой карты

будет использовано устройство Virtio.

Виртуальная машина автоматически получит ip-адрес из подсети 10.0.2.0/24, шлюз

- 10.0.2.2, dns-сервер - 10.0.2.3.

К физическому хосту можно обратиться по адресу 10.0.2.2.

ICMP пакеты через такой тип сети не проходят.

Виртуальная сеть с использованием tap-устройств

В данном режиме при запуске ВМ в физической системе будет создано виртуальное

сетевое tap-устройство, что потребует root прав

sudo qemu-kvm \

-m 1G \

-device virtio-net-pci,netdev=lan \

-netdev tap,id=lan,ifname=tap0 \

-drive file=/tmp/livecd.iso,media=cdrom

При таких настройках машина запустится, но не будет иметь доступа к физической

сети. Для предоставления доступа необходимо создать сетевой мост, добавить в

него физический сетевой адаптер хоста и настроить скрипты добавления

виртуального сетевого tap-устройства в сетевой мост.

Предположим, что физический хост подключен к сети через адаптер enp3s0 и имеет

адрес 192.168.1.50/24, шлюз 192.168.1.1.

Удалим все сетевые настройки у адаптера enp3s0 и создадим сетевой мост с помощью Network Manager:

root# nmcli connection show

root# nmcli connection delete <имя подключения enp3s0>

root# nmcli connection add type bridge ifname br0 con-name bridge bridge.stp false ipv4.method manual ipv4.addresses "192.168.1.50/24" ipv4.gateway 192.168.1.1 ipv6.method disabled

Добавляем физический адаптер хоста в сетевой мост:

nmcli con add type bridge-slave ifname enp3s0 con-name nicHost master br0

Настраиваем скрипт добавления виртуального сетевого tap-устройства к мосту - /etc/qemu-ifup:

#!/bin/sh

/usr/sbin/brctl addif br0 $1

/usr/sbin/ip link set dev $1 up

Скрипт удаления tap-устройства из моста /etc/qemu-ifdown:

#!/bin/sh

/usr/sbin/ip link set dev $1 down

/usr/sbin/brctl delif br0 $1

В скриптах $1 указывает на имя виртуального сетевого адаптера (tap0, tap1 и т.п.).

Если потребуется разместить скрипты по другому пути, то их месторасположение

можно указать в свойствах виртуального сетевого устройства с помощью директив

script и downscript:

sudo qemu-kvm \

-m 1G \

-device virtio-net-pci,netdev=lan \

-netdev tap,id=lan,ifname=tap0,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-drive file=/tmp/livecd.iso,media=cdrom

Запускаем виртуальную машину и проверяем сеть.

Виртуальная машина автоматически получит ip-адрес из подсети 10.0.2.0/24, шлюз

- 10.0.2.2, dns-сервер - 10.0.2.3.

К физическому хосту можно обратиться по адресу 10.0.2.2.

ICMP пакеты через такой тип сети не проходят.

Виртуальная сеть с использованием tap-устройств

В данном режиме при запуске ВМ в физической системе будет создано виртуальное

сетевое tap-устройство, что потребует root прав

sudo qemu-kvm \

-m 1G \

-device virtio-net-pci,netdev=lan \

-netdev tap,id=lan,ifname=tap0 \

-drive file=/tmp/livecd.iso,media=cdrom

При таких настройках машина запустится, но не будет иметь доступа к физической

сети. Для предоставления доступа необходимо создать сетевой мост, добавить в

него физический сетевой адаптер хоста и настроить скрипты добавления

виртуального сетевого tap-устройства в сетевой мост.

Предположим, что физический хост подключен к сети через адаптер enp3s0 и имеет

адрес 192.168.1.50/24, шлюз 192.168.1.1.

Удалим все сетевые настройки у адаптера enp3s0 и создадим сетевой мост с помощью Network Manager:

root# nmcli connection show

root# nmcli connection delete <имя подключения enp3s0>

root# nmcli connection add type bridge ifname br0 con-name bridge bridge.stp false ipv4.method manual ipv4.addresses "192.168.1.50/24" ipv4.gateway 192.168.1.1 ipv6.method disabled

Добавляем физический адаптер хоста в сетевой мост:

nmcli con add type bridge-slave ifname enp3s0 con-name nicHost master br0

Настраиваем скрипт добавления виртуального сетевого tap-устройства к мосту - /etc/qemu-ifup:

#!/bin/sh

/usr/sbin/brctl addif br0 $1

/usr/sbin/ip link set dev $1 up

Скрипт удаления tap-устройства из моста /etc/qemu-ifdown:

#!/bin/sh

/usr/sbin/ip link set dev $1 down

/usr/sbin/brctl delif br0 $1

В скриптах $1 указывает на имя виртуального сетевого адаптера (tap0, tap1 и т.п.).

Если потребуется разместить скрипты по другому пути, то их месторасположение

можно указать в свойствах виртуального сетевого устройства с помощью директив

script и downscript:

sudo qemu-kvm \

-m 1G \

-device virtio-net-pci,netdev=lan \

-netdev tap,id=lan,ifname=tap0,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-drive file=/tmp/livecd.iso,media=cdrom

Запускаем виртуальную машину и проверяем сеть.

ВМ получила адрес от DHCP сервера локальной сети.

Проверяем состав сетевого моста на физическом хосте с помощью команды brctl show:

ВМ получила адрес от DHCP сервера локальной сети.

Проверяем состав сетевого моста на физическом хосте с помощью команды brctl show:

В хост-системе появилось устройство tap0, и оно автоматически добавилось в сетевой мост.

По-умолчанию, все виртуальные сетевые адаптеры получают MAC адрес

52:54:00:12:34:56, если потребуется запустить несколько виртуальных машин на

хосте, то необходимо указать разные адреса с помощью параметра mac:

sudo qemu-kvm \

-m 1G \

-device virtio-net-pci,mac=52:54:00:00:00:01,netdev=lan \

-netdev tap,id=lan,ifname=tap0,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-drive file=/tmp/livecd.iso,media=cdrom

Подготовка виртуальных дисков

Ранее мы запускали ВМ с LiveCD. Для того чтобы установить операционную систему

в виртуальную машину нам понадобится создать виртуальные диски для хранения данных.

Создание виртуальных дисков

qemu-img create -f qcow2 vmpath/disk.qcow2 20G

Данная команда создаст "тонкий" диск в формате qcow2, объёмом 20 Гб.

Если потребуется создать кластерный диск, то необходимо для него всё место

выделить заранее и использовать тип диска raw:

qemu-img create -f raw -o preallocation=falloc shared/shared.raw 10G

Использование снимков состояния дисков

Формат дисков qcow2 позволяет создавать и удалять внутри диска снимки состояний (снапшоты):

создание снимка:

qemu-img snapshot -c snapshotName vmpath/disk.qcow2

список снимков:

qemu-img snapshot -l vmpath/disk.qcow2

применить снимок (вернуть диск в состояние на момент снимка):

qemu-img snapshot -a snapshotName vmpath/disk.qcow2

удалить снимок:

qemu-img snapshot -d snapshotName vmpath/disk.qcow2

Вся работа со снимками будет производится внутри одного образа, что может потребовать времени.

Другим способом создания снимков состояний является создание промежуточного

файла (backing file) - при создании такого файла вся запись будет вестись в

него вместо базового образа:

qemu-img create -f qcow2 -F qcow2 -b vmpath/disk.qcow2 vmpath/backingDisk.qcow2

При запуске ВМ указываем в качестве диска промежуточный файл:

qemu-kvm -m 1G -drive file=vmpath/backingDisk.qcow2,media=disk

Чтобы откатить снапшот, достаточно перенастроить запуск на изначальный образ

диска и удалить снапшот.

qemu-kvm -m 1G -drive file=vmpath/disk.qcow2 ,media=disk

rm vmpath/backingDisk.qcow2

Изменение первоначального образа приведёт к повреждению снапшота, поэтому после

запуска ВМ с оригинальным диском все снапшоты станут бесполезными.

Подключение разделов виртуального диска к хост-системе

Если возникнет необходимость обратиться к файлам на виртуальном диске напрямую

с хост-системы, то необходимо сначала смонтировать образ. Для того, чтобы

смонтировать разделы виртуального диска к хост-системе необходимо

воспользоваться утилитой qemu-nbd.

1. Загружаем модуль ядра nbd

root# modprobe nbd max_part=8

2. Подключаем образ виртуального диска как сетевое блочное устройство:

root# qemu-nbd --connect=/dev/nbd0 vmpath/disk.qcow2

3. Выполняем нужные нам операции с устройством:

root# fdisk /dev/nbd0 -l

root# mount /dev/nbd0p1 /mnt/volume/

root# umount /dev/nbd0p1

4. Отключаем устройство

root# qemu-nbd --disconnect /dev/nbd0

root# rmmod nbd

Запуск виртуальной машины с BIOS в Qemu KVM

По-умолчанию Qemu KVM запускает виртуальные машины с BIOS, поэтому особых настроек не требуется.

Готовим диск для гостевой системы:

qemu-img create -f qcow2 /mnt/virtual/bios/bios.qcow2 20G

Запускаем ВМ:

sudo qemu-kvm \

-machine pc \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=2,sockets=1,cores=2 \

-m 1G \

-k en-us \

-vga qxl \

-rtc base=localtime \

-netdev tap,id=lan,ifname=tap0,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-device virtio-net-pci,mac=52:54:00:00:00:01,netdev=lan \

-drive file=/mnt/virtual/bios/bios.qcow2,if=virtio,media=disk,index=0 \

-drive file=/mnt/shared/linuxos.iso,media=cdrom,index=1

Параметры:

machine - свойства чипсета, основные это pc (совместимый со многими и ОС) и

q35 (поддерживает новые устройства)

smbios - описание BIOS

cpu - тип эмулируемого ЦП, host указывает использовать как в физической системе

accel - тип ускорение виртуализации

smp - описываем кол-во виртуальных ядер ЦП и их распределение по сокетам

m - объём ОЗУ

k - раскладка клавиатуры консоли

vga - тип виртуального видеоадаптера

rtc base - настройки часов RTC

netdev/device и drive - описание сетевой карты и виртуальных дисков

Загружаемся с CD-ROM и устанавливаем ОС.

Запуск виртуальной машины с UEFI в Qemu KVM

Для запуска виртуальной машины с UEFI нам потребуются прошивки из пакета edk2-ovmf.

Готовим виртуальный диск для гостевой системы:

qemu-img create -f qcow2 /mnt/virtual/uefi/uefi.qcow2 20G

Из пакета edk2-ovmf копируем образы UEFI и NVRAM:

cp /usr/share/edk2/ovmf/OVMF_CODE.fd /mnt/virtual/uefi

cp /usr/share/edk2/ovmf/OVMF_VARS.fd /mnt/virtual/uefi

Запускаем ВМ:

sudo qemu-kvm \

-machine q35 \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=4,sockets=1,cores=4 \

-m 4G \

-k en-us \

-vga qxl \

-device virtio-net-pci,mac=52:54:00:00:00:02,netdev=lan \

-netdev tap,id=lan,ifname=tap1,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-drive if=pflash,format=raw,readonly=on,file=/mnt/virtual/uefi/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=/mnt/virtual/uefi/OVMF_VARS.fd \

-drive file=/mnt/virtual/uefi/uefi.qcow2,if=virtio,media=disk \

-drive file=/mnt/shared/linuxos.iso,media=cdrom

Подключаем прошивку UEFI для чтения с помощью drive if=pflash с указанием

readonly=on, а также файл для хранения NVRAM, но уже в режиме записи.

Загружаемся с CD-ROM и устанавливаем ОС.

Запуск виртуальных машин с UEFI с общим кластерным диском в Qemu KVM

Рассмотрим пример запуска двух машин, где у каждой будет свой индивидуальный

диск для ОС и один общий диск для кластера.

Подключать диски будем с помощью устройства -device virtio-blk-pci, оно

позволяет включить совместную запись на диск с нескольких виртуальных машин c

помощью параметра share-rw=on.

Готовим диски для гостевых систем:

qemu-img create -f qcow2 /mnt/virtual/cluster/vm1-system.qcow2 20G

qemu-img create -f qcow2 /mnt/virtual/cluster/vm2-system.qcow2 20G

Для кластерного диска используем формат raw и заранее резервируем место.

qemu-img create -f raw -o preallocation=falloc /mnt/virtual/cluster/shared.raw 10G

Копируем образы прошивки UEFI и NVRAM:

cp /usr/share/edk2/ovmf/OVMF_CODE.fd /mnt/virtual/cluster

cp /usr/share/edk2/ovmf/OVMF_VARS.fd /mnt/virtual/cluster/OVMF_VARS_VM1.fd

cp /usr/share/edk2/ovmf/OVMF_VARS.fd /mnt/virtual/cluster/OVMF_VARS_VM2.fd

Запускаем ВМ 1:

sudo qemu-kvm \

-machine q35 \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=2,sockets=1,cores=2 \

-m 2G \

-k en-us \

-vga qxl \

-device virtio-net-pci,netdev=lan,mac=52:54:00:00:00:11 \

-netdev tap,id=lan,ifname=tap11 \

-drive if=pflash,format=raw,readonly=on,file=/mnt/virtual/cluster/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=/mnt/virtual/cluster/OVMF_VARS_VM1.fd \

-device virtio-blk-pci,drive=drive0,share-rw=off \

-drive file=/mnt/virtual/cluster/vm1-system.qcow2,id=drive0,format=qcow2,if=none \

-device virtio-blk-pci,drive=drive1,share-rw=on \

-drive file=/mnt/virtual/cluster/shared.raw,id=drive1,format=raw,if=none \

-drive file=/mnt/shared/linuxos.iso,media=cdrom

Запускаем ВМ 2:

sudo qemu-kvm \

-machine q35 \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=2,sockets=1,cores=2 \

-m 2G \

-k en-us \

-vga qxl \

-device virtio-net-pci,netdev=lan,mac=52:54:00:00:00:12 \

-netdev tap,id=lan,ifname=tap12 \

-drive if=pflash,format=raw,readonly=on,file=/mnt/virtual/cluster/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=/mnt/virtual/cluster/OVMF_VARS_VM2.fd \

-device virtio-blk-pci,drive=drive0,share-rw=off \

-drive file=/mnt/virtual/cluster/vm2-system.qcow2,id=drive0,format=qcow2,if=none \

-device virtio-blk-pci,drive=drive1,share-rw=on \

-drive file=/mnt/virtual/cluster/shared.raw,id=drive1,format=raw,if=none \

-drive file=/mnt/shared/linuxos.iso,media=cdrom

Далее нужно установить ОС внутри ВМ и настроить работу с кластерным диском.

В хост-системе появилось устройство tap0, и оно автоматически добавилось в сетевой мост.

По-умолчанию, все виртуальные сетевые адаптеры получают MAC адрес

52:54:00:12:34:56, если потребуется запустить несколько виртуальных машин на

хосте, то необходимо указать разные адреса с помощью параметра mac:

sudo qemu-kvm \

-m 1G \

-device virtio-net-pci,mac=52:54:00:00:00:01,netdev=lan \

-netdev tap,id=lan,ifname=tap0,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-drive file=/tmp/livecd.iso,media=cdrom

Подготовка виртуальных дисков

Ранее мы запускали ВМ с LiveCD. Для того чтобы установить операционную систему

в виртуальную машину нам понадобится создать виртуальные диски для хранения данных.

Создание виртуальных дисков

qemu-img create -f qcow2 vmpath/disk.qcow2 20G

Данная команда создаст "тонкий" диск в формате qcow2, объёмом 20 Гб.

Если потребуется создать кластерный диск, то необходимо для него всё место

выделить заранее и использовать тип диска raw:

qemu-img create -f raw -o preallocation=falloc shared/shared.raw 10G

Использование снимков состояния дисков

Формат дисков qcow2 позволяет создавать и удалять внутри диска снимки состояний (снапшоты):

создание снимка:

qemu-img snapshot -c snapshotName vmpath/disk.qcow2

список снимков:

qemu-img snapshot -l vmpath/disk.qcow2

применить снимок (вернуть диск в состояние на момент снимка):

qemu-img snapshot -a snapshotName vmpath/disk.qcow2

удалить снимок:

qemu-img snapshot -d snapshotName vmpath/disk.qcow2

Вся работа со снимками будет производится внутри одного образа, что может потребовать времени.

Другим способом создания снимков состояний является создание промежуточного

файла (backing file) - при создании такого файла вся запись будет вестись в

него вместо базового образа:

qemu-img create -f qcow2 -F qcow2 -b vmpath/disk.qcow2 vmpath/backingDisk.qcow2

При запуске ВМ указываем в качестве диска промежуточный файл:

qemu-kvm -m 1G -drive file=vmpath/backingDisk.qcow2,media=disk

Чтобы откатить снапшот, достаточно перенастроить запуск на изначальный образ

диска и удалить снапшот.

qemu-kvm -m 1G -drive file=vmpath/disk.qcow2 ,media=disk

rm vmpath/backingDisk.qcow2

Изменение первоначального образа приведёт к повреждению снапшота, поэтому после

запуска ВМ с оригинальным диском все снапшоты станут бесполезными.

Подключение разделов виртуального диска к хост-системе

Если возникнет необходимость обратиться к файлам на виртуальном диске напрямую

с хост-системы, то необходимо сначала смонтировать образ. Для того, чтобы

смонтировать разделы виртуального диска к хост-системе необходимо

воспользоваться утилитой qemu-nbd.

1. Загружаем модуль ядра nbd

root# modprobe nbd max_part=8

2. Подключаем образ виртуального диска как сетевое блочное устройство:

root# qemu-nbd --connect=/dev/nbd0 vmpath/disk.qcow2

3. Выполняем нужные нам операции с устройством:

root# fdisk /dev/nbd0 -l

root# mount /dev/nbd0p1 /mnt/volume/

root# umount /dev/nbd0p1

4. Отключаем устройство

root# qemu-nbd --disconnect /dev/nbd0

root# rmmod nbd

Запуск виртуальной машины с BIOS в Qemu KVM

По-умолчанию Qemu KVM запускает виртуальные машины с BIOS, поэтому особых настроек не требуется.

Готовим диск для гостевой системы:

qemu-img create -f qcow2 /mnt/virtual/bios/bios.qcow2 20G

Запускаем ВМ:

sudo qemu-kvm \

-machine pc \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=2,sockets=1,cores=2 \

-m 1G \

-k en-us \

-vga qxl \

-rtc base=localtime \

-netdev tap,id=lan,ifname=tap0,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-device virtio-net-pci,mac=52:54:00:00:00:01,netdev=lan \

-drive file=/mnt/virtual/bios/bios.qcow2,if=virtio,media=disk,index=0 \

-drive file=/mnt/shared/linuxos.iso,media=cdrom,index=1

Параметры:

machine - свойства чипсета, основные это pc (совместимый со многими и ОС) и

q35 (поддерживает новые устройства)

smbios - описание BIOS

cpu - тип эмулируемого ЦП, host указывает использовать как в физической системе

accel - тип ускорение виртуализации

smp - описываем кол-во виртуальных ядер ЦП и их распределение по сокетам

m - объём ОЗУ

k - раскладка клавиатуры консоли

vga - тип виртуального видеоадаптера

rtc base - настройки часов RTC

netdev/device и drive - описание сетевой карты и виртуальных дисков

Загружаемся с CD-ROM и устанавливаем ОС.

Запуск виртуальной машины с UEFI в Qemu KVM

Для запуска виртуальной машины с UEFI нам потребуются прошивки из пакета edk2-ovmf.

Готовим виртуальный диск для гостевой системы:

qemu-img create -f qcow2 /mnt/virtual/uefi/uefi.qcow2 20G

Из пакета edk2-ovmf копируем образы UEFI и NVRAM:

cp /usr/share/edk2/ovmf/OVMF_CODE.fd /mnt/virtual/uefi

cp /usr/share/edk2/ovmf/OVMF_VARS.fd /mnt/virtual/uefi

Запускаем ВМ:

sudo qemu-kvm \

-machine q35 \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=4,sockets=1,cores=4 \

-m 4G \

-k en-us \

-vga qxl \

-device virtio-net-pci,mac=52:54:00:00:00:02,netdev=lan \

-netdev tap,id=lan,ifname=tap1,script=/etc/qemu-ifup,downscript=/etc/qemu-ifdown \

-drive if=pflash,format=raw,readonly=on,file=/mnt/virtual/uefi/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=/mnt/virtual/uefi/OVMF_VARS.fd \

-drive file=/mnt/virtual/uefi/uefi.qcow2,if=virtio,media=disk \

-drive file=/mnt/shared/linuxos.iso,media=cdrom

Подключаем прошивку UEFI для чтения с помощью drive if=pflash с указанием

readonly=on, а также файл для хранения NVRAM, но уже в режиме записи.

Загружаемся с CD-ROM и устанавливаем ОС.

Запуск виртуальных машин с UEFI с общим кластерным диском в Qemu KVM

Рассмотрим пример запуска двух машин, где у каждой будет свой индивидуальный

диск для ОС и один общий диск для кластера.

Подключать диски будем с помощью устройства -device virtio-blk-pci, оно

позволяет включить совместную запись на диск с нескольких виртуальных машин c

помощью параметра share-rw=on.

Готовим диски для гостевых систем:

qemu-img create -f qcow2 /mnt/virtual/cluster/vm1-system.qcow2 20G

qemu-img create -f qcow2 /mnt/virtual/cluster/vm2-system.qcow2 20G

Для кластерного диска используем формат raw и заранее резервируем место.

qemu-img create -f raw -o preallocation=falloc /mnt/virtual/cluster/shared.raw 10G

Копируем образы прошивки UEFI и NVRAM:

cp /usr/share/edk2/ovmf/OVMF_CODE.fd /mnt/virtual/cluster

cp /usr/share/edk2/ovmf/OVMF_VARS.fd /mnt/virtual/cluster/OVMF_VARS_VM1.fd

cp /usr/share/edk2/ovmf/OVMF_VARS.fd /mnt/virtual/cluster/OVMF_VARS_VM2.fd

Запускаем ВМ 1:

sudo qemu-kvm \

-machine q35 \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=2,sockets=1,cores=2 \

-m 2G \

-k en-us \

-vga qxl \

-device virtio-net-pci,netdev=lan,mac=52:54:00:00:00:11 \

-netdev tap,id=lan,ifname=tap11 \

-drive if=pflash,format=raw,readonly=on,file=/mnt/virtual/cluster/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=/mnt/virtual/cluster/OVMF_VARS_VM1.fd \

-device virtio-blk-pci,drive=drive0,share-rw=off \

-drive file=/mnt/virtual/cluster/vm1-system.qcow2,id=drive0,format=qcow2,if=none \

-device virtio-blk-pci,drive=drive1,share-rw=on \

-drive file=/mnt/virtual/cluster/shared.raw,id=drive1,format=raw,if=none \

-drive file=/mnt/shared/linuxos.iso,media=cdrom

Запускаем ВМ 2:

sudo qemu-kvm \

-machine q35 \

-smbios type=1,manufacturer=oVirt,product=RHEL,version=1 \

-cpu host \

-accel kvm \

-smp cpus=2,sockets=1,cores=2 \

-m 2G \

-k en-us \

-vga qxl \

-device virtio-net-pci,netdev=lan,mac=52:54:00:00:00:12 \

-netdev tap,id=lan,ifname=tap12 \

-drive if=pflash,format=raw,readonly=on,file=/mnt/virtual/cluster/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=/mnt/virtual/cluster/OVMF_VARS_VM2.fd \

-device virtio-blk-pci,drive=drive0,share-rw=off \

-drive file=/mnt/virtual/cluster/vm2-system.qcow2,id=drive0,format=qcow2,if=none \

-device virtio-blk-pci,drive=drive1,share-rw=on \

-drive file=/mnt/virtual/cluster/shared.raw,id=drive1,format=raw,if=none \

-drive file=/mnt/shared/linuxos.iso,media=cdrom

Далее нужно установить ОС внутри ВМ и настроить работу с кластерным диском.

|

| |

|

|

|

Использование инструментария Podman для запуска контейнеров во FreeBSD (доп. ссылка 1) |

[комментарии]

|

| | Начиная с выпуска FreeBSD 14.2 стали формироваться образы контейнеров в

формате OCI (Open Container Initiative). Для запуска контейнеров на основе

этих образов можно применять инструментарий Podman, который портирован для

FreeBSD и доступен для установки из пакетов.

Для загрузки предложены три варианта образов FreeBSD:

static - урезанное окружение для выполнения только статически собранных исполняемых файлов

dynamic - расширенный вариант окружения static с компонентами для

использования разделяемых библиотек и запуска динамически скомпонованных

исполняемых файлов.

minimal - дополняет вариант dynamic утилитами для формирования привычного

консольного окружения с UNIX shell и пакетным менеджером.

Установка Podman во FreeBSD.

pkg install -r FreeBSD -y podman-suite emulators/qemu-user-static

Настройка ZFS-раздела для контейнеров:

zfs create -o mountpoint=/var/db/containers zroot/containers

zfs snapshot zroot/containers@empty

При желании использовать UFS вместо ZFS в

/usr/local/etc/containers/storage.conf заменяем "zfs"/driver на "vfs":

sed -I .bak -e 's/driver = "zfs"/driver = "vfs"/' \

/usr/local/etc/containers/storage.conf

Создаём конфигурацию межсетевого экрана PF - /etc/pf.conf, используя пример

/usr/local/etc/containers/pf.conf.sample. Перезапускаем PF

sysctl net.pf.filter_local=1

service pf restart

Монтируем /dev/fd:

mount -t fdescfs fdesc /dev/fd

Создаём необходимые для Podman файлы конфигурации, используя примеры:

/usr/local/etc/containers/containers.conf.sample

/usr/local/etc/containers/policy.json.sample

/usr/local/etc/containers/registries.conf.sample

/usr/local/etc/containers/storage.conf.sample

Устанавливаем образы контейнеров minimal, dynamic и static с FreeBSD 4.2:

export OCIBASE=https://download.freebsd.org/releases/OCI-IMAGES/14.2-RELEASE/amd64/Latest

podman load -i=$OCIBASE/FreeBSD-14.2-RELEASE-amd64-container-image-minimal.txz

podman load -i=$OCIBASE/FreeBSD-14.2-RELEASE-amd64-container-image-dynamic.txz

podman load -i=$OCIBASE/FreeBSD-14.2-RELEASE-amd64-container-image-static.txz

Проверяем список установленных образов контейнеров командами "podman images" и "buildah images":

podman images

REPOSITORY TAG IMAGE ID CREATED SIZE

localhost/freebsd14-minimal 14.2-RELEASE-amd64 c5f3e77557a9 4 days ago 35.1 MB

localhost/freebsd14-dynamic 14.2-RELEASE-amd64 ebf7538b22f4 4 days ago 15.9 MB

localhost/freebsd14-static 14.2-RELEASE-amd64 7876fe59dbb3 4 days ago 5.45 MB

buildah images

REPOSITORY TAG IMAGE ID CREATED SIZE

localhost/freebsd14-minimal 14.2-RELEASE-amd64 c5f3e77557a9 4 days ago 35.1 MB

localhost/freebsd14-dynamic 14.2-RELEASE-amd64 ebf7538b22f4 4 days ago 15.9 MB

localhost/freebsd14-static 14.2-RELEASE-amd64 7876fe59dbb3 4 days ago 5.45 MB

Анализируем слои, образующие образ minimal, который является надстройкой над

образами static и dynamic:

podman image tree localhost/freebsd14-minimal:14.2-RELEASE-amd64

Image ID: c5f3e77557a9

Tags: [localhost/freebsd14-minimal:14.2-RELEASE-amd64]

Size: 35.07MB

Image Layers

├── ID: cd53fb07fb66 Size: 5.449MB Top Layer of: [localhost/freebsd14-static:14.2-RELEASE-amd64]

├── ID: a01d37f7777b Size: 10.4MB Top Layer of: [localhost/freebsd14-dynamic:14.2-RELEASE-amd64]

└── ID: 36b0c80ca1f7 Size: 19.21MB Top Layer of: [localhost/freebsd14-minimal:14.2-RELEASE-amd64]

Сверяем контрольные суммы образов:

podman inspect localhost/freebsd14-minimal:14.2-RELEASE-amd64

Запускаем /bin/sh в контейнере:

podman run -it localhost/freebsd14-minimal:14.2-RELEASE-amd64 /bin/sh

|

| |

|

|

|

Проброс графического адаптера в виртуальную машину KVM |

Автор: anon1233456

[комментарии]

|

| | Для проброса графического адаптера в виртуальную машину KVM следует указать

при загрузке параметры ядра

rd.driver.pre=vfio_pci rd.driver.pre=vfio-pciwq iommu=pt intel_iommu=on kvm.ignore_msrs=1

и добавить vfio-pci в initramfs:

# as Root

gpu="0000:06:00.0"

aud="0000:06:00.1"

gpu_vd="$(cat /sys/bus/pci/devices/$gpu/vendor) $(cat /sys/bus/pci/devices/$gpu/device)"

aud_vd="$(cat /sys/bus/pci/devices/$aud/vendor) $(cat /sys/bus/pci/devices/$aud/device)"

function bind_vfio {

echo "$gpu" > "/sys/bus/pci/devices/$gpu/driver/unbind"

echo "$aud" > "/sys/bus/pci/devices/$aud/driver/unbind"

# https://www.kernel.org/doc/Documentation/ABI/testing/sysfs-bus-pci

echo "$gpu_vd" > /sys/bus/pci/drivers/vfio-pci/new_id

echo "$aud_vd" > /sys/bus/pci/drivers/vfio-pci/new_id

}

function unbind_vfio {

echo "$gpu_vd" > "/sys/bus/pci/drivers/vfio-pci/remove_id"

echo "$aud_vd" > "/sys/bus/pci/drivers/vfio-pci/remove_id"

echo 1 > "/sys/bus/pci/devices/$gpu/remove"

echo 1 > "/sys/bus/pci/devices/$aud/remove"

echo 1 > "/sys/bus/pci/rescan"

}

bind_vfio

#QEMU emulator version 8.2.2 (qemu-8.2.2-1.fc40)

NETWORK_DEVICE="virtio-net"

MAC_ADDRESS="00:16:cb:00:21:19"

# 0x28 - Raptor Lake fix. https://github.com/tianocore/edk2/discussions/4662

CPU="host,host-phys-bits-limit=0x28"

args=(

-display gtk,grab-on-hover=on,full-screen=on

-machine q35

-accel kvm

-cpu $CPU

-m size=17338368k

-overcommit mem-lock=off

-smp 32,sockets=1,dies=1,clusters=1,cores=32,threads=1

-no-user-config

-nodefaults

-rtc base=localtime,driftfix=slew

-global kvm-pit.lost_tick_policy=delay

-global ICH9-LPC.disable_s3=1

-global ICH9-LPC.disable_s4=1

-boot menu=off,strict=on

-device qemu-xhci,id=xhci

# VFIO

# VERY IMPORTANT PART. PLEASE NOTE THE FORMAT OF COMMAND

# id":"pci.5","bus":"pcie.0","addr":"0x2.0x4" and "id":"pci.6","bus":"pcie.0","addr":"0x2.0x5"

-device pcie-root-port,bus=pcie.0,id=pci_root,multifunction=true,addr=0x2

-device '{"driver":"pcie-root-port","port":20,"chassis":5,"id":"pci.5","bus":"pcie.0","addr":"0x2.0x4"}'

-device '{"driver":"pcie-root-port","port":21,"chassis":6,"id":"pci.6","bus":"pcie.0","addr":"0x2.0x5"}'

-device '{"driver":"vfio-pci","host":"0000:06:00.0","id":"gpu","bus":"pci.5","addr":"0x0"}'

-device '{"driver":"vfio-pci","host":"0000:06:00.1","id":"hdmiaudio","bus":"pci.6","addr":"0x0"}'

#

-drive id=HDD,if=virtio,file="$HDD",format=qcow2

# Network

-netdev user,id=net0

-device "$NETWORK_DEVICE",netdev=net0,id=net0,mac="$MAC_ADDRESS"

#

-device virtio-serial-pci

-usb

-device usb-kbd

-device usb-tablet

-monitor stdio

# Audio

-audiodev pa,id=aud1,server="/run/user/1000/pulse/native"

-device ich9-intel-hda

-device hda-duplex,audiodev=aud1

#

-device qxl-vga,vgamem_mb=128,vram_size_mb=128

-device virtio-balloon-pci

)

qemu-system-x86_64 "${args[@]}"

unbind_vfio

|

| |

|

|

|

Подключение в BHyVe zvol-диска с другой машины |

Автор: КриоМух

[комментарии]

|

| | Ситуация такова: Когда-то давно в 2019 году, обратилась знакомая бухгалтер, с

проблемой, что вирусы зашифровали все её базы 1С, хранящиеся на личном сервере,

который ей поднял и оформил для работы по RDP - её айтишник. Когда вирус всё

пожрал, внезапно обнаружилось, что отсутствуют резервные копии, так как они

хранились на том же WIN-сервере, и оказались также пожранными. Более того, в

процессе разбирательств с этой машиной, выяснилось, что там 4 диска, 2 - HDD и

2 SSD - и при этом все они отдельными устройствами, без намёка на хоть какую-то

реализацию зеркалирования. Айтишника этого она с позором выгнала (отказавшись с

ним иметь дело) и обратилась ко мне.

Понятно что не за восстановлением пожранного, а за организацией сервера, в

работе и надёжности которого она бы могла быть уверена.

Я как старый пользователь FreeBSD, конечно сразу ей сформировал предложение -

эту её машину превратить в сервер на FreeBSD, а уже на нём развернуть виртуалку

с виндой, 1С и всей этой нужной для её работы кухней.

На предложение докупить ещё один ПК, чтобы был отдельной машиной для резервных

копий - отказалась, так как женщина она во-первых бухгалтер, а во-вторых

прижимистый бухгалтер :)

Всё ей в итоге оформил в виде хоста на FreeBSD, c её ZFS-ным зеркалом на 2 HDD

и 2 SSD, и самбой, на которую складировались ежедневные бэкапы, которые затем

скриптом самого хоста перекладывались в samba-ресурс, доступный только на чтение.

Виртуалку оформил на BHyVe'е, так как виртуалбокс медленнен, а BHyVe и

православный и производительней. Sparse - файлом оформил диск на HDD-пуле под

систему в виртуалке, и SSD-пул - подключил zvol'ом как диск под базы 1С.

Разворачивал BHyVe не голый, а с управлением с помощью vm-bhyve. Всё

завелось и работало, как часы. Но через год-полтора, женщина-бухгалтер и со

мной "рассталась", так как всё работало, а я за поддержку желал ежемесячную,

оговорённую сумму.

Никаких козней я понятное дело не строил, да и не собирался, так как честь

IT-шную беречь должно всегда. И все актуальные копии хранилища со всеми

доступами и чего там наворочено в её "инфраструктуре" я ей при внесении правок

сразу высылал и при завершении сотрудничества также актуальную выдал, с

пояснениями, что там всё что есть, все доступы и прочая-прочая, что может

понадобиться знать любому, кто будет заниматься её сервером. Ответы на все

вопросы так сказать. Всё.

Собственно прошло 3-4 года, и вот недавно звонит она мне и говорит, что всё

пропало. Сервак не грузится, её текущий админ не знает что со всем этим делать,

так как с его слов "там сложная распределённая система и диски эти не может

посмотреть". Короче сервак подох, ничего не работает, и ей главное выцарапать

оттуда 1С базы.

Получил, включил, смотрю: Действительно ничего не грузится, что-то там с uefi

разделом, и загрузка дохнет на начальных этапах. Думаю - ничего страшного, там

же бэкапы были, сейчас быстренько смонтирую пул, да последний достану и дело с

концом. Загрузился с флешки, подмонтировал пул, который был HDD, под самбу -

смотрю а бэкап последний лежит прошлогодний. Место на пуле закончилось, так как

самбу они ещё и как файловую шару использовали и накидали туда всякого, что

подъело весь ресурс и баз видимо 1С ещё добавилось, и бэкапы делаться просто не

смогли, а текущий специалист, то ли не следил, то ли не знал как следить,

короче перефразируя (надеюсь) из тех, кто: "Не следил и не проверял бэкапы, но

теперь уже будет всегда это делать (ещё раз надеюсь)".

Тогда остался один путь - получить данные непосредственно с диска в виртуалке,

который реализован был как отдельный датасет на SSD пуле. Отцепил я значит один

из SSD'шников и подключил к своему домашнему ПК, на котором у меня также

FreeBSD и виртуалка BHyVe, с виндой, на случай если что-то виндовое

потребуется. В общем вся соль этого была в подключении к BHyVe'овой машине

диска оформленного как сырой ZFS-датасет. То есть в нём ни файлов нет, просто

особого типа ZFS датасет.

В итоге, чтобы его подключить на посторонней системе с FreeBSD, надо конечно

первым делом ZFS-пул импортировать:

zpool import -f

-f нужен, так как он ругнётся что этот пул использовался на другой машине и

вроде как может не надо его тут подключать.

А после этого в

zfs list

ищем где наш датасет и объявляем его в конфигурации нашей рабочей виртуалки:

disk1_type="virtio-blk"

disk1_dev="custom"

disk1_name="/dev/zvol/oldSSD/BHYVE/1C-BASES"

И это тут так всё просто и безоблачно описано, а на деле я часа два наверное

бодался с тем, как именно объявить zvol-овый диск в BHyVe. И в итоге

disk_type - должен быть virtio-blk

disk_dev - должен быть custom

disk_name - абсолютный путь к zvol'у в /dev, сперва это можно просто проверить ls'ом.

Ну а дальше - ещё в самой загруженной ОСи диск не увиделся, но появился SCSI

контроллер какой-то, который потребовал драйвера с диска

virtio-win-0.1.229 и всё.

Женщина - оплатила услуги непростого восстановления файлов, получила инструктаж

на тему того, что её админ должен ей подтверждать что бэкап есть и он надёжен.

Ну а она со своей стороны должна за этим бдить :)

|

| |

|

|

|

Запуск macOS в виртуальной машине на базе QEMU/KVM (доп. ссылка 1) (доп. ссылка 2) (доп. ссылка 3) |

[комментарии]

|

| | Скрипт для запуска macOS в виртуальной машине (файлы с прошивками можно

скопировать из snap sosum, proxmox или пакета ovmf из Fedora, Ubuntu или Debian).

#!/bin/bash

OSK="ourhardworkbythesewordsguardedpleasedontsteal(c)AppleComputerInc"

/usr/bin/qemu-system-x86_64 \

-enable-kvm \

-m 2G \

-machine q35,accel=kvm \

-smp 4,cores=2 \

-cpu Penryn,vendor=GenuineIntel,kvm=on,+sse3,+sse4.2,+aes,+xsave,+avx,+xsaveopt,+xsavec,+xgetbv1,+avx2,+bmi2,+smep,+bmi1,+fma,+movbe,+invtsc \

-device isa-applesmc,osk="$OSK" \

-smbios type=2 \

-object rng-random,id=rng0,filename=/dev/urandom -device virtio-rng-pci,rng=rng0 \

-serial mon:stdio \

-drive if=pflash,format=raw,readonly,file=./firmware/OVMF_CODE.fd \

-drive if=pflash,format=raw,file=./firmware/OVMF_VARS-1024x768.fd \

-device virtio-vga,virgl=on \

-display sdl,gl=on \

-L "$SNAP"/usr/share/seabios/ \

-L "$SNAP"/usr/lib/ipxe/qemu/ \

-audiodev pa,id=pa,server="/run/user/$(id -u)/pulse/native" \

-device ich9-intel-hda -device hda-output,audiodev=pa \

-usb -device usb-kbd -device usb-mouse \

-netdev user,id=net0 \

-device vmxnet3,netdev=net0,id=net0 \

-drive id=ESP,if=virtio,format=qcow2,file=./ESP.qcow2 \

-drive id=SystemDisk,if=virtio,file=./macos.qcow2

Для установки macOS в виртуальной машине c использованием образа BaseSystem.img

дополнительно нужно добавить строку:

-drive id=InstallMedia,format=raw,if=virtio,file=./BaseSystem.img

Для загрузки установочного образа macOS можно использовать скрипт fetch-macos.py.

|

| |

|

|

|

vmhgfs в старых CentOS и RHEL |

Автор: пох

[комментарии]

|

| | Если понадобилось достучаться из CentOS 6 до хостового shared folder в VMware

Workstation или чем-то совместимом, а стандартные способы приводят только к

появлению загадочных мусорных сообщений в логах, что что-то где-то кого-то не

нашло, можно поступить так:

Поставить vmware-tools от VMware (да, понадобится перл и может даже gcc).

Ключевой момент - _целиком_. Понадобится версия 8.любая (я свою стащил из

vsphere5.0, но вообще-то они доступны с родного сайта даже без регистрации и sms).

Если в системе подключен EPEL, из которого установлен open-vm-tools - его

потребуется удалить через yum erase, так как это устаревший и неработающий

бэкпорт. Также понадобиться удалить уже установленные модули (как минимум сам

модуль vmhgfs), полученные из других источников.

В чем суть? В том, что как обычно - эру немого кино объявили deprecated, а со

звуковым что-то пошло не так. В десятой версии VMware перешла на новый-модный

метод доступа к hgfs через fuse - в чем не было бы ничего плохого (дергать

гипервизор все равно, из ядра или userspace), если бы, разумеется, всё было

реализовано корректно. Прибить гвоздем непрошенное кэширование, игнорируя

существующие API - норм. Исправить нельзя - "я в отпуске!" (по возвращении

исправлено не то и не до конца, потом переисправлено, но с уровнем

единственного штатного разработчика и качеством его кода, надеюсь, уже все ясно).

Поэтому нет смысла пол-системы апгрейдить ради "поддерживаемой" таким способом мусорной версии.

Ключевой момент при этом - что устанавливать старые vmware-tools надо целиком -

чтобы mount.vmhgfs был той же самой (старой!) версии, что и vmhgfs.ko -

поскольку там, внезапно, тоже stable api is nonsense - поэтому и необходимо

удалить "опен"-vm-tools - ничего хорошего они не содержат. API самого

гипервизора при этом не меняется (или там хорошо сохраняют обратную

совместимость) поэтому модуль работает с любой версией.

P.S. Если у вас именно штатный CentOS/RHEL, все пройдет гладко, а если что-то

несколько отличающееся и придётся модуль пересобирать из исходников - в

vmhgfs-only/fsutil.c в 65й строке исправьте "if" так, чтобы он всегда был

"false" - там проверка минимальной версии, которая неправильна из-за сделанного

rh бэкпортирования патчей, вам этот блок не нужен.

|

| |

|

|

|

Сборка ChromiumOS из исходных текстов для запуска в QEMU (доп. ссылка 1) |

[комментарии]

|

| | Доступный в исходных текстах ChromiumOS главным образом отличается отсутствием

элементов брендинга ChromeOS и компонентов DRM для просмотра защищённого контента.

Для сборки вначале нужно клонировать репозиторий с инструментарием:

git clone https://chromium.googlesource.com/chromium/tools/depot_tools.git

export PATH=$PATH:$PWD/depot_tools

После чего можно приступить к загрузке и сборки исходных текстов ChromiumOS

(сборку осуществляем для целевой платформы amd64-generic, при низкой скорости

сети или недосаточном свободном дисковом пространстве в "repo init" также можно

указать опцию "-g minilayout" для загрузки минимально необходимого набора кода):

mkdir chromiumos

cd chromiumos

repo init -u https://chromium.googlesource.com/chromiumos/manifest.git --repo-url https://chromium.googlesource.com/external/repo.git -g minilayout

repo sync -j75

cros_sdk

export BOARD=amd64-generic

./setup_board --board=${BOARD}

./build_packages --board=${BOARD}

./build_image --board=${BOARD} --boot_args "earlyprintk=serial,keep console=tty0" --noenable_rootfs_verification test

./image_to_vm.sh --board=${BOARD} --test_image

Для запуска окружения ChromiumOS можно воспользоваться командной cros_start_vm:

cros_sdk

./bin/cros_start_vm --image_path=../build/images/${BOARD}/latest/chromiumos_qemu_image.bin --board=${BOARD}

но при использовании cros_start_vm наблюдаются мешающие полноценной работе

ограничения, такие как невозможность перенаправить графический вывод через VNC.

Поэтому будем запускать ChromiumOS при помощи QEMU и виртуального GPU Virglrenderer.

Установим сборочные зависимости (список для Ubuntu 17.10):

sudo apt install autoconf libaio-dev libbluetooth-dev libbrlapi-dev \

libbz2-dev libcap-dev libcap-ng-dev libcurl4-gnutls-dev libepoxy-dev \

libfdt-dev \

libgbm-dev libgles2-mesa-dev libglib2.0-dev libgtk-3-dev libibverbs-dev \

libjpeg8-dev liblzo2-dev libncurses5-dev libnuma-dev librbd-dev librdmacm-dev \

libsasl2-dev libsdl1.2-dev libsdl2-dev libseccomp-dev libsnappy-dev l\

ibssh2-1-dev libspice-server-dev libspice-server1 libtool libusb-1.0-0 \

libusb-1.0-0-dev libvde-dev libvdeplug-dev libvte-dev libxen-dev valgrind \

xfslibs-dev xutils-dev zlib1g-dev libusbredirhost-dev usbredirserver

Соберём Virglrenderer, который позволяет задействовать виртуальный GPU и

использовать из гостевой системы графические возможности хост-системы, в том

числе аппаратное ускорение для OpenGL. Virglrenderer является не обязательным,

если не нужно ускорение вывода графики можно обойтись без сборки Virglrenderer

и убрать из строки запуска QEMU "virgl".

git clone git://git.freedesktop.org/git/virglrenderer

cd virglrenderer

./autogen.sh

make -j7

sudo make install

Собираем QEMU для целевой платформы x86_64:

git clone git://git.qemu-project.org/qemu.git

mkdir -p qemu/build

cd qemu/build

../configure --target-list=x86_64-softmmu --enable-gtk --with-gtkabi=3.0 \

--enable-kvm --enable-spice --enable-usb-redir --enable-libusb --enable-virglrenderer --enable-opengl

make -j7

sudo make install

Запускаем ChromiumOS в QEMU с использованием драйверов virtio (Linux-ядро

хост-системы должно быть собрано с опциями CONFIG_DRM_VIRTIO,

CONFIG_VIRT_DRIVERS и CONFIG_VIRTIO_XXXX):

cd chromiumos

/usr/local/bin/qemu-system-x86_64 \

-enable-kvm \

-m 2G \

-smp 4 \

-hda src/build/images/amd64-generic/latest/chromiumos_qemu_image.bin \

-vga virtio \

-net nic,model=virtio \

-net user,hostfwd=tcp:127.0.0.1:9222-:22 \

-usb -usbdevice keyboard \

-usbdevice mouse \

-device virtio-gpu-pci,virgl \

-display gtk,gl=on

|

| |

|

|

|

Сборка системы виртуализации crosvm из Chrome OS в обычном дистрибутиве Linux (доп. ссылка 1) |

[комментарии]

|

| | В Chrome/Chromium OS для изоляции приложений развивается система crosvm,

основанная на использовании гипервизора KVM. Код crosvm написан на языке Rust

и примечателен наличием дополнительного уровня защиты на основе пространств

имён, применяемого для защиты от атак на инструментарий виртуализации.

Из других особенностей crosvm отмечаются встроенные средства для запуска

Wayland-клиентов внутри изолированных окружений с выполнением композитного

сервера на стороне основного хоста и возможность эффективного использования GPU

из гостевых систем. Подобные возможности делают crosvm интересным решением для

изолированного запуска графических приложений.

Crosvm не привязан к Chromium OS и может быть собран и запущен в любом

дистрибутиве Linux (протестировано в Fedora 26).

Собираем ядро Linux для гостевой системы:

cd ~/src

git clone git://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git

cd linux

git checkout v4.12

make x86_64_defconfig

make bzImage

cd ..

Собираем инструментарий minijail для запуска программ в изолированных окружениях:

git clone https://android.googlesource.com/platform/external/minijail

cd minijail

make

cd ..

Собираем crosvm:

git clone https://chromium.googlesource.com/a/chromiumos/platform/crosvm

cd crosvm

LIBRARY_PATH=~/src/minijail cargo build

Генерируем образ корневой ФС (rootfs) для изолированного окружения:

cd ~/src/crosvm

dd if=/dev/zero of=rootfs.ext4 bs=1K count=1M

mkfs.ext4 rootfs.ext4

mkdir rootfs/

sudo mount rootfs.ext4 rootfs/

debootstrap testing rootfs/

sudo umount rootfs/

Запускаем crosvm:

LD_LIBRARY_PATH=~/src/minijail ./target/debug/crosvm run -r rootfs.ext4 --seccomp-policy-dir=./seccomp/x86_64/ ~/src/linux/arch/x86/boot/compressed/vmlinux.bin

|

| |

|

|

|

Создание чистого openvz-контейнера на основе CentOS 6 (доп. ссылка 1) |

Автор: umask

[комментарии]

|

| | Разработчики OpenVZ предлагают загрузить заранее созданные шаблоны

контейнеров, но у этих шаблонов есть недостаток - в них присутствует довольно

много лишних пакетов, которые не хотелось бы вычищать руками. Помимо этого, в

этих шаблонах присутствуют неподписаные пакеты, а так же репозиторий с

пакетами-заглушками, цифровая подпись пакетов из которого не проверяется. В

общем всё это и заставило сделать свой собственный чистый контейнер с нуля.

Далее предлагается скрипт, который в хост-системе на основе centos6 создаёт

чистый контейнер с это же самой ОС.

Сам скрипт:

#!/bin/bash

### exit on errors (in pipes too) and verbose execution

set -o pipefail -e -x

TMPDIR=$(mktemp -d)

VEID=777

DESTDIR=/vz/private/${VEID}

### veid config

cat << _EOF_ > /etc/vz/conf/${VEID}.conf

# This config is only valid for decent VSwap-enabled kernel

# (version 042stab042 or later).

ONBOOT="yes"

# RAM

PHYSPAGES="0:2G"

# Swap

SWAPPAGES="0:0G"

# Disk quota parameters (in form of softlimit:hardlimit)

DISKSPACE="20G:22G"

DISKINODES="200000:220000"

QUOTATIME="0"

# CPU fair scheduler parameter

CPUUNITS="1000"

VE_ROOT="/vz/root/\\$VEID"

VE_PRIVATE="/vz/private/\\$VEID"

OSTEMPLATE="centos-6-secured-x86_64"

ORIGIN_SAMPLE="basic"

HOSTNAME="localhost"

SEARCHDOMAIN=""

NAMESERVER="8.8.8.8 8.8.4.4"

IP_ADDRESS="10.20.30.40"

CPULIMIT="100"

CPUS="1"

_EOF_

### stop / destroy if exists / recreate

vzctl stop ${VEID}

[[ -d ${DESTDIR} ]] && rm -rf ${DESTDIR}

mkdir -p ${DESTDIR}

mkdir -p /vz/root/${VEID}

### init rpm db

rpm --root ${DESTDIR} --initdb

### download packages for create base directory

yum install -q -y yum-utils

yumdownloader --destdir ${TMPDIR} centos-release centos-release-cr

### install base directory rpms

TO_INSTALL=""

for i in ${TMPDIR}/*.rpm; do

TO_INSTALL="${TO_INSTALL} ${i}"

done

rpm --root ${DESTDIR} -i ${TO_INSTALL}

### Save random seed

touch ${DESTDIR}/var/lib/random-seed

chmod 600 ${DESTDIR}/var/lib/random-seed

dd if=/dev/urandom of=/var/lib/random-seed count=1 bs=512 2>/dev/null

### import centos pubkey

rpm --root ${DESTDIR} --import /etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-6

### install required rpms

yum --installroot=${DESTDIR} install -q -y postfix filesystem tzdata glibc procps \\

coreutils rpm yum yum-utils udev openssh basesystem bash grep MAKEDEV \\

openssl gnupg2 logrotate rsyslog screen openssh-server openssh-clients \\

info ca-certificates libuuid sed vim-enhanced findutils iproute tmpwatch \\

wget curl patch vixie-cron sysstat htop telnet which diffutils rsync \\

sudo yum-cron psacct lftp tcpdump numactl git vconfig nc xz bzip2 \\

nscd passwd tar

### pts only in fstab

cat << _EOF_ > ${DESTDIR}/etc/fstab

none /dev/pts devpts gid=5,mode=620 0 0

_EOF_

chmod 0644 ${DESTDIR}/etc/fstab

mkdir -p ${DESTDIR}/dev/pts

### create devices

for INPATH in dev etc/udev/devices; do

/sbin/MAKEDEV -x -d ${DESTDIR}/${INPATH} console core fd full kmem kmsg mem null port \\

ptmx {p,t}ty{a,p}{0,1,2,3,4,5,6,7,8,9,a,b,c,d,e,f} random \\

urandom zero ram{,0,1,disk} std{in,out,err}

done

### do not run agetty's

sed -i 's/^ACTIVE_CONSOLES=\\(.*\\)/#ACTIVE_CONSOLES=\\1\\nACTIVE_CONSOLES=""/g' ${DESTDIR}/etc/sysconfig/init

### run minimum services

SERVICES="(network|crond|sshd|sysstat|snmpd|syslog|psacct|udev-post|nscd)"

chroot ${DESTDIR} "/sbin/chkconfig" "--list" | grep -oP '^\\S+' | \\

sort | uniq | egrep -vE "${SERVICES}" | xargs -I{} chroot ${DESTDIR} "/sbin/chkconfig" "{}" "off"

chroot ${DESTDIR} "/sbin/chkconfig" "--list" | grep -oP '^\\S+' | \\

sort | uniq | egrep -E "${SERVICES}" | xargs -I{} chroot ${DESTDIR} "/sbin/chkconfig" "{}" "--level" "2345" "on"

### clock/timezone

cat << _EOF_ > ${DESTDIR}/etc/sysconfig/clock

ZONE="Europe/Moscow"

_EOF_

chroot ${DESTDIR} "/usr/sbin/tzdata-update"

### make mtab actual every time

chroot ${DESTDIR} 'rm' '-fv' '/etc/mtab'

chroot ${DESTDIR} 'ln' '-s' '/proc/mounts' '/etc/mtab'

### cleanup

rm -rf ${TMPDIR}

### set locale to UTF

cat << _EOF_ > ${DESTDIR}/etc/sysconfig/i18n

LANG="en_US.UTF-8"

SYSFONT="latarcyrheb-sun16"

_EOF_

chroot ${DESTDIR} 'localedef' '-c' '-f' 'UTF-8' '-i' 'en_US' '/usr/lib/locale/en_US.utf8'

### TODO:

### 1. check ssh keys and delete them

### 2. make template.tar.gz

После создания контейнера я удаляю ssh host keys и делаю дамп контейнера

утилитой vzdump, а затем клонирую контейнеры через vzrestore. При желании можно

сделать шаблон самостоятельно, например как написано здесь или здесь.

|

| |

|

|

|

Сборка ядра FreeBSD для выполнения в роли паравиртуализированной гостевой системы под управлением Xen (доп. ссылка 1) |

[комментарии]

|

| | В репозитории http://svn.freebsd.org/base/projects/amd64_xen_pv/ доступны

свежие версии драйверов для обеспечения работы гостевых систем FreeBSD в режиме

паравиртуализации под управлением Xen.

Для сборки паравиртуализированного ядра FreeBSD для Xen можно использовать следующую инструкцию:

mkdir /dirprefix/

mkdir /amd64_xen_pv/

svn checkout svn://svn.freebsd.org/base/projects/amd64_xen_pv/ /amd64_xen_pv/

cd /amd64_xen_pv/

setenv MAKEOBJDIRPREFIX ../dirprefix/

make -j10 -s buildkernel KERNCONF=XEN

В результате ядро и необходимые модули будут размещены в директории ../dirprefix/amd64_xen_pv/sys/XEN/kernel

|

| |

|

|

|

Настройка сетевого доступа в окружениях QEMU |

Автор: Аноним

[комментарии]

|

| | Заметка о том, как настроить сеть между гостевой и хостовой ОС при

использовании QEMU. В качестве хостовой ОС Ubuntu 10.04.

На стороне хоста устанавливаем uml-utilities:

sudo apt-get install uml-utilities

Это нужно делать только один раз. Создаем сетевой интерфейс:

sudo tunctl -t qemu

Вешаем на него адрес и включаем:

sudo ip address add 192.168.0.1/24 dev qemu

sudo ip link set up dev qemu

Запускаем qemu (например):

sudo qemu-system-x86_64 -hda HDD.img -cdrom FreeBSD-9.0-RC1-amd64-dvd1.iso \\

-net nic -net tap,ifname=qemu,script=no,downscript=no -boot d

Делаем простой NAT на хостовой ОС:

sudo bash -c 'echo 1 > /proc/sys/net/ipv4/ip_forward'

sudo iptables -t nat -A POSTROUTING -o eth0 -j MASQUERADE

На гостевой cистеме прописываем конфигурацию маршрута по-умолчанию и конфигурацию DNS-клиента.

Еще небольшая рекомендация: запускайте qemu на десктопе под управлением утилиты

screen. Это спасет вас, если вы вдруг решите закрыть окно терминала, в котором

запустили qemu.

screen -S qemu sudo qemu-system-x86_64 ...

Потом делаем detach (^D) и закрываем окно терминала.

|

| |

|

|

|

Установка XCP XenAPI в Ubuntu 11.10 или Debian GNU/Linux (доп. ссылка 1) |

[комментарии]

|

| | Благодаря портированию XCP XenAPI для Debian и Ubuntu Linux у пользователей

данных дистрибутивов появилась возможность создания сервера виртуализации,

функционально эквивалентного стандартному дистрибутиву XCP на базе CentOS.

В процессе развертывания Xen хоста следует не поддастся искушению установки

пакета с ядром Linux, оканчивающегося на "-virtual". Такие ядра в Ubuntu/Debian

оптимизированы для использования внутри гостевых систем и не сконфигурированы

для использования в роли Dom0.

После установки XAPI будут запущены сервисы, использующие сетевые порты 80 и

443. Поэтому важно проследить, чтобы на текущем сервере до этого не был запущен

http-сервер или настроить раздельный запуск XAPI на другом IP. При

использовании VPN и сетевого интерфейса tun0, наблюдается ряд проблем, которые

могут привести к невозможности запуска XAPI.

Установка XAPI

Устанавливаем компоненты XAPI из специального PPA-репозитория ubuntu-xen-org.

Добавляем в /etc/apt/sources.list

deb http://ppa.launchpad.net/ubuntu-xen-org/xcp-unstable/ubuntu oneiric main

deb-src http://ppa.launchpad.net/ubuntu-xen-org/xcp-unstable/ubuntu oneiric main

или подключаем репозиторий для Debian:

apt-get install curl

echo "deb http://downloads.xen.org/XCP/debian/repo/debian unstable main" > /etc/apt/sources.list.d/kronos.list

echo "deb-src http://downloads.xen.org/XCP/debian/repo/debian unstable main" >> /etc/apt/sources.list.d/kronos.list

wget --quiet -O - http://downloads.xen.org/XCP/debian/xcp.gpg.key | apt-key add -

Устанавливаем xapi:

apt-get update

apt-get install xcp-xapi

Вариант сборки свежей версии инструментария XCP из исходных текстов с

использованием xapi-autobuilder.

Устанавливаем необходимые для сборки компоненты:

apt-get install pbuilder debhelper dh-ocaml dh-autoreconf cdebootstrap python-debian mercurial git

wget http://downloads.xen.org/XCP/debian/blktap-dkms_0.1_all.deb

dpkg -i blktap-dkms_0.1_all.deb

Клонируем Git-репозиторий xapi-autobuilder и выполняем сборку:

git clone https://github.com/jonludlam/xapi-autobuilder.git

cd xapi-autobuilder

make clean ; make

в итоге будут подготовлены необходимые для установки в Debian пакеты, свежие

версии которых также можно загрузить командой:

wget -r -l1 --no-parent -nd http://downloads.xen.org/XCP/debian/latest/

rm index.html*

Настройка XAPI

Активируем по умолчанию опцию загрузки Xen в Grub:

sed -i 's/GRUB_DEFAULT=""/GRUB_DEFAULT="Xen 4.1-amd64"/' /etc/default/grub

update-grub

Настраиваем параметры сети

В /etc/network/interfaces добавляем запуск интерфейсе xenbr0:

auto lo xenbr0

iface xenbr0 inet dhcp

bridge_ports eth0

Вместо "dhcp" при необходимости можно прописать статический IP.

Настраиваем содержимое файла xensource-inventory (в скрипте ниже

подразумевается, что корневой раздел /dev/sda1, а управляющий сетевой интерфейс

xenbr0). Для генерации xensource-inventory запускаем простой shell-скрипт:

control_domain=`uuidgen`

installation=`uuidgen`

cat > /etc/xensource-inventory << EOF

CURRENT_INTERFACES='xenbr0'

BUILD_NUMBER='0'

CONTROL_DOMAIN_UUID='${control_domain}'

INSTALLATION_UUID='${installation}'

MANAGEMENT_INTERFACE='xenbr0'

PRIMARY_DISK='/dev/sda1'

EOF

Перезагружаем систему

reboot

Использование XCP

Убедимся, что xapi запущен

service xapi status

если нет, то запустим его командой

service xapi start

Добавим к переменноё окружения PATH путь к исполняемым файлам xapi:

export PATH=$PATH:/usr/lib/xen-common/xapi/bin

Создадим репозиторий хранения. Рекомендуется использовать NFS или EXT, если в

системе есть свободное блочное устройство.

Для NFS (в переменную SR будет записан идентификатор хранилища):

SR=`xe sr-create type=nfs name-label=nfs device-config:server=<nfs server> device-config:serverpath=<path on server>`

Для незанятого блочного устройства /dev/sda3 (внимание, указанный раздел будет отформатирован !)

SR=`xe sr-create type=ext device-config:device=/dev/sda3 name-label=ext`

Свяжем созданное хранилище с пулом:

POOL=`xe pool-list --minimal`

xe pool-param-set uuid=$POOL default-SR=$SR

Решение проблемы с памятью для Dom0

В штатном ядре Ubuntu 11.10 наблюдается проблема с выделением недостаточного

объема памяти для Dom0. Данная проблема решена в ядре 3.2. В качестве обходного

пути решения, можно вручную увеличить размер выделенной для нужд Dom0 памяти

(посмотреть текущее значением можно через "cat /proc/meminfo" ).

Находим uuid идентификатор Dom0:

xe vm-list

uuid ( RO) : f5d0039b-1138-4635-c153-6203bfdc330f

name-label ( RW): Control domain on host: piggy

power-state ( RO): running

Вручную назначаем нижний и верхний лимит памяти:

xe vm-param-set uuid=f5d0039b-1138-4635-c153-6203bfdc330f memory-dynamic-max=2GiB

xe vm-param-set uuid=f5d0039b-1138-4635-c153-6203bfdc330f memory-dynamic-min=2GiB

Установка гостевой системы с Linux

Находим шаблон для установки интересующего дистрибутива:

xe template-list

Ниже представленный скрипт позволяет автоматизировать выполнение установки.

Скрипт следует запускать из локальной системы (Dom0), но его можно легко

модифицировать для организации удалённой установки с другого хоста. На

завершающем этапе работы скрипта будет произведён запуск виртуальной машины для

выполнения финального этапа установки.

В скрипте может понадобиться поменять следующие переменные:

"vm-label" - метка для ссылки на VM из Dom0;

"hostname" - имя хоста;

"domain" - локальный домен

В качестве шаблона для установки выбран Ubuntu Lucid Lynx 10.04 (64-bit)

#!/bin/bash

set -e

set -x

template=`xe template-list name-label="Ubuntu Lucid Lynx 10.04 (64-bit)" --minimal`

vm=`xe vm-install template=$template new-name-label=vm-label`

network=`xe network-list bridge=xenbr0 --minimal`

vif=`xe vif-create vm-uuid=$vm network-uuid=$network device=0`

xe vm-param-set uuid=$vm other-config:install- repository=http://archive.ubuntu.com/ubuntu

xe vm-param-set uuid=$vm PV-args="auto-install/enable=true interface=auto netcfg/dhcp_timeout=600 hostname=vm-host-name domain=mydomain.is.best"

xe vm-start uuid=$vm

Для завершения установки следует подключиться к виртуальной машине, например, через "xe console"

Перед этим следует запустить демон xapissl:

service start xapissl

Список активных консолей VM можно посмотреть командой: